L'INTERVISTA

mercoledì 18 Ottobre, 2023

Federico Faggin, l’inventore dei microchip e dei primi touch-screen: «Il computer futuro non avrà coscienza o libero arbitrio»

di Simone Casciano

Classe 1941, è un fisico originario di Vicenza che dagli anni Sessanta si è trasferito negli Stati Uniti: «L’intelligenza artificiale ci aiuterà, usiamola con etica e giudizio»

Riproponiamo una delle interviste più apprezzate dalle lettrici e dai lettori del T nel corso del 2023.

Il fuoco, la ruota e poi la macchina. Ci sono state alcune invenzioni capaci di trasformare radicalmente l’umanità, di farle fare un balzo in avanti tanto veloce quanto sorprendente. Talmente profonde da incidere una linea di demarcazione netta tra il prima e il dopo. Basti pensare alla lampadina, a come abbia permesso di conquistare la notte, oppure al treno e all’aereo, che hanno azzerato le distanze fisiche. Nello stesso pantheon delle più importanti invenzioni rientra anche il microchip, sono infatti questi microscopici circuiti che hanno permesso di ridurre le dimensioni dei computer, moltiplicandone contemporaneamente la capacità di calcolo. Una scoperta che ha un padre italiano: Federico Faggin. Nato a Vicenza nel 1941, laureato in fisica all’Università di Padova si è poi trasferito negli Stati Uniti dove ha inventato il primo processore con ponte in silicio e poi è stato fondatore dell’azienda, negli anni ’80, capace di sviluppare i primi touchpad e touch-screen. Faggin è stato ospite della quinta Giornata dell’innovazione organizzata dall’ordine degli ingegneri del Trentino.

Faggin le fa piacere il titolo di «padre del microchip»?

«Mi fa sentire bene perché l’ho progettato e l’ho portato da idea a realtà, facendo una cosa che, come idea, esisteva già, ma ancora non era realtà. Si sapeva che nel futuro l’unità centrale di un computer sarebbe stato un chip ma bisognava realizzarlo. Io ho sviluppato la tecnologia e l’ho realizzata materialmente, quindi sì mi sento davvero il padre del microchip. Il circuito integrato era già stato realizzato nel 1962, ma io ho sviluppato per la prima volta, nel 1967, la tecnologia Mos con porta di silicio. Una tecnologia completamente nuova che permetteva di realizzare circuiti integrati molto più potenti. La possibilità di inserire nella stessa area un maggior numero di transistor e la minore dispersione di corrente hanno permesso davvero di pensare e realizzare i pc a partire da un chip. L’Intel ha poi preso quella tecnologia e io li ho seguiti perché non volevo lasciare la mia invenzione nelle mani di qualcun altro e perché erano quelli che si muovevano più velocemente. Realizzammo il processore 4004, poi l’8008 e infine l’8080 che ha lanciato la rivoluzione dei microprocessori».

Una rivoluzione che ha cambiato drasticamente il futuro dell’umanità, ma di cui forse ci rendiamo conto di meno rispetto ad altre invenzioni?

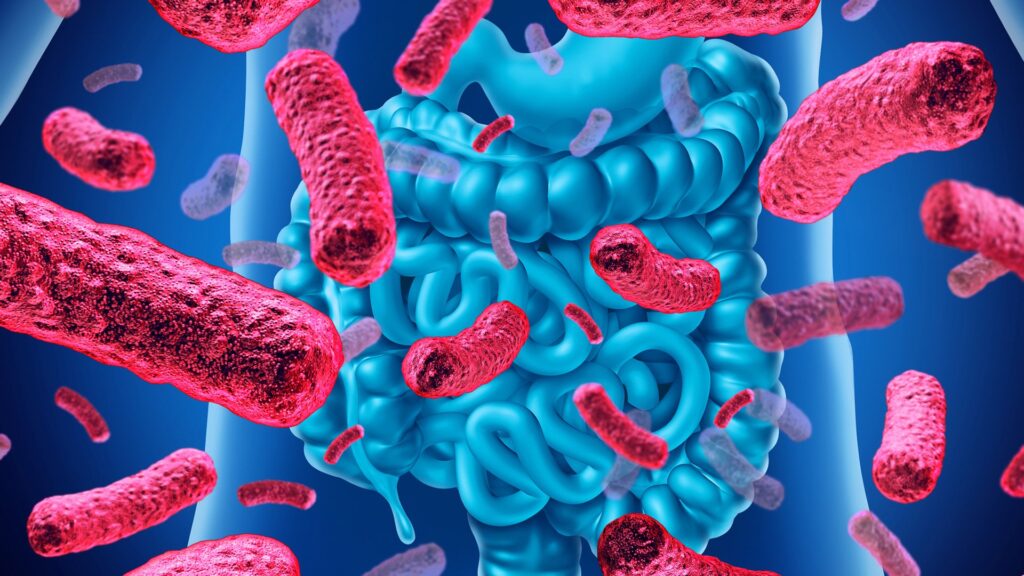

«Sì, è vero, il microchip, per definizione, è meno visibile e quindi forse ce ne accorgiamo meno. Ma senza questa tecnologia avanzata, che dalla sua invenzione in poi ha progressivamente continuato a raddoppiare la propria potenza ogni due anni, molto di quello che esiste oggi non sarebbe stato possibile. Questo processo ha reso possibili tantissime nuove applicazioni. Dal chip arrivano i personal computer che hanno spalancato il mondo dell’informatica a milioni di utenti. Questa base di utenti voleva connettersi ed è quindi nato internet. I telefoni portatili prima e soprattutto gli smartphone poi sono diventati dei minicomputer che hanno messo nelle mani delle persone, su dispositivi mobili, applicazioni che prima era impensabile potessero funzionare su quelle piattaforme. Tutto questo è stato reso possibile dai microchip, anche ora il progresso delle intelligenze artificiali si basa sulla potenza dei microprocessori che permettere ad esse di avere la potenza di calcolo necessaria ai processi di apprendimento automatico».

La produzione di microchip è così essenziale da essere diventata materia di geopolitica.

«Sì, una situazione che si è creata perché nel tempo gli Stati Uniti e l’Europa sono rimasti indietro. Quando c’ero io Intel era due generazioni di microchip davanti a tutti come produzione, ora invece ha perso la leadership. All’avanguardia adesso c’è Taiwan che è due generazioni davanti a tutti e al secondo posto c’è la Korea che è una generazione davanti all’occidente. Questo crea un problema non indifferente».

Qual è, secondo lei, lo stato della ricerca e dell’innovazione in Italia?

«Ci sono dei centri di eccellenza, ma sappiamo che in Italia non si investe in ricerca e sviluppo quanto in altri paesi avanzati. Mancano tante cose, ma la prima sono proprio i soldi perché poi questa carenza si traduce in stipendi più bassi per i laureati che escono dalle nostre università e se uno è bravo allora ha gioco facile a trovare offerte migliori all’estero. Molte più persone oggi lasciano l’Italia rispetto al passato proprio per questo motivo».

Qual è il futuro dell’innovazione in campo tecnologico?

«Il lavoro più importante al momento è quello sullo sviluppo dei computer quantistici, ma per ora esiste soltanto un piccolo numero di algoritmi quantistici noti per la loro capacità di generare un vantaggio in termini di velocità nei processi. Uno di questi algoritmi si occupa di decifrare informazioni criptate in tempi molto più brevi rispetto alle capacità dei computer classici. Per quel che riguarda invece i microprocessori penso che stiamo arrivando ormai alla fine della corsa della cosiddetta Legge di Moore. Siamo arrivati a processi di fabbricazione sui 3 nanometri, si potrà scendere a 2, forse anche a 1, ma poi ci si fermerà probabilmente».

Cosa ne pensa dell’Intelligenza artificiale?

«Credo che sia un grande passo avanti dal punto di vista tecnologico, che può aiutare tantissimo le persone se utilizzata con giudizio e etica, ma può anche essere utilizzata male e creare problemi. Può dare una mano però in tanti lavori, anche intellettuali, che facciamo, ma sempre a patto che chi la utilizza ne sappia di più dell’intelligenza artificiale».

Proprio sulle differenze tra pensiero umano e computer si è concentrato negli ultimi anni.

«Sì, ciò a cui mi sono dedicato negli ultimi 20 anni, assieme al professore Giacomo Mauro D’Ariano, è uno studio sulla teoria della coscienza e del libero arbitrio. Possiamo dire che il computer classico, anche quello del futuro, non avrà mai coscienza o libero arbitrio. In questa nuova teoria abbiamo dimostrato come coscienza e libero arbitrio siano proprietà della fisica quantistica, esistono quindi solo nel mondo quantistico. Questo dà all’uomo il suo giusto merito, di essere più di una macchina. La teoria dimostra che solo l’uomo è capace di capire e comprendere e sgombra il campo dagli annunci di computer coscienti. Noi siamo esseri coscienti che usano un corpo fisico, lo controlliamo come una periferica. Siamo quindi enti quantistici che controllano un corpo che agisce nel mondo della fisica classica. Questo significa anche un’altra cosa: che l’idea che, quando il corpo muore noi non ci siamo più non è valida. Noi continuiamo ad esistere anche dopo la morte del corpo».

l'intervista

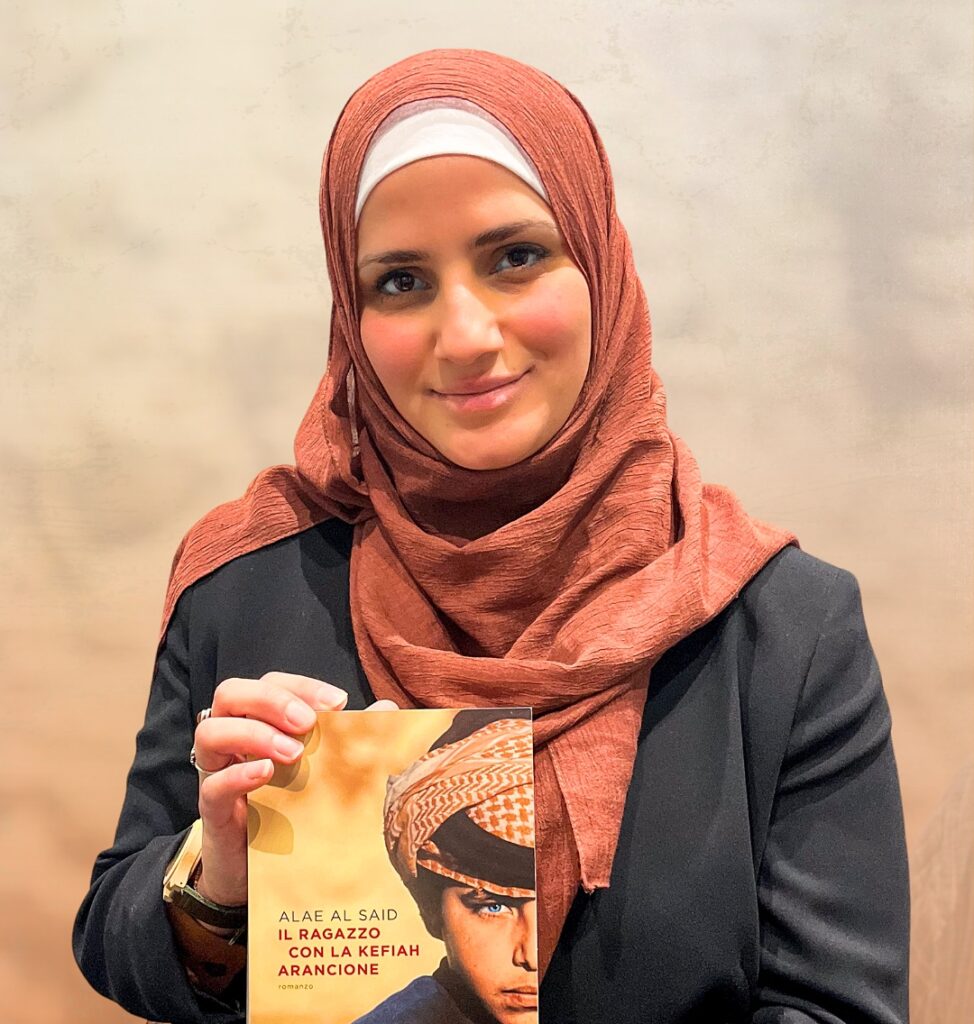

Alae Al Said: «La mia Palestina tra checkpoint e umiliazioni. Ai miei cugini, nelle carceri israeliane, spaccarono le ginocchia a martellate»

di Sara Alouani

L'autrice, nata a Roma, oggi a Lavarone, presenterà il suo romanzo «Il ragazzo con la kefiah arancione»: «Sogno un unico Stato dove ebrei, cristiani e musulmani possano vivere in pace»

L'intervista

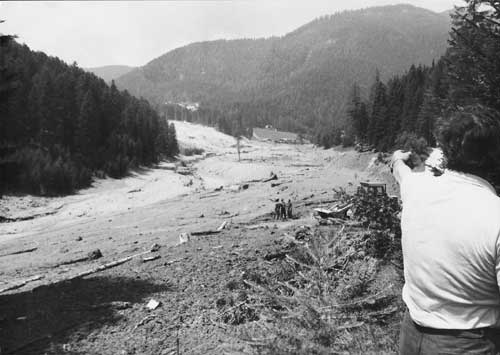

L'altra Stava di Claudio Doliana: «Lavoravo al pronto soccorso di Cavalese, capii cos’era successo dall’odore dei feriti che arrivarono»

di Daniele Benfanti

Quarant'anni fa lavorava al triage del nosocomio, oggi ha pubblicato un libro: «Quella miniera e i due bacini di decantazione non dovevano essere lì»